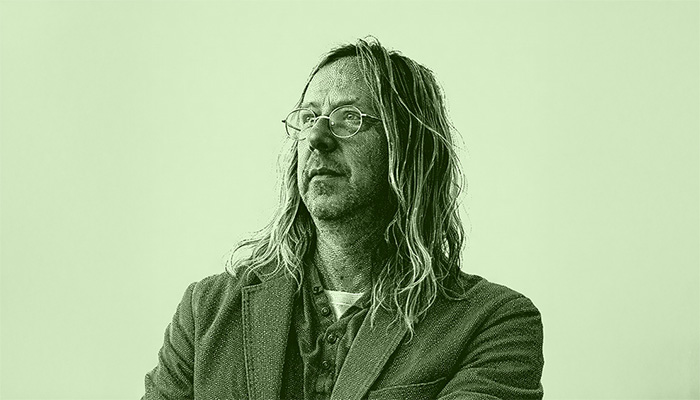

Le intelligenze artificiali generative stanno modificando le modalità in cui impariamo e lavoriamo. Come sempre il dibattito si divide tra ottimisti e pessimisti. Lei dove si posiziona?

Sono ragionevolmente ottimista sul fatto che i sistemi di intelligenza artificiale risolveranno almeno alcuni fra i loro problemi di gioventù, come per esempio le allucinazioni. Non lo sono particolarmente sull’impatto di questi sistemi sul mondo del lavoro, sull’economia e la società nel suo complesso. La mia impressione è che il saldo, in termini di occupazione, sarà negativo. E penso che questa situazione imporrà di rispolverare un vecchio slogan: lavorare meno, lavorare tutti. Ma alla riduzione dell’orario di lavoro, secondo me, dovrebbe corrispondere un incremento del tempo dedicato alla formazione continua, interpretandola però in modo nuovo. Abbiamo sempre pensato al lifelong learning soprattutto in chiave di aggiornamento per le singole professioni. Invece dovremmo apprendere una nuova generazione di competenze di base, incluse molte nuove competenze di cittadinanza digitale che, penso, dovrebbero essere fornite a tutte e a tutti. Questi programmi dovrebbero coinvolgere la scuola e l’università, sia come istituzioni che gestiscono il lifelong learning, sia come sedi di molte fra le relative attività di apprendimento. Ma non sono troppo ottimista sul fatto che i nostri sistemi sociali, economici, politici abbiano la capacità e la volontà di seguire questa strada.

Un secondo aspetto su cui non sono ottimista riguarda i rischi collegati all’uso dell’intelligenza artificiale, che sono enormi e in crescita. Non mi preoccupano tanto gli scenari fantascientifici sulle AI che prendono il potere, per quanto serva cautela: si tratta di sistemi che non capiamo fino in fondo e che possono manifestare proprietà inattese. Per me i rischi principali riguardano la diffusione di modelli di medie dimensioni, che sfuggono più facilmente all’approccio normativo e legislativo su cui si lavora oggi. Già oggi chiunque può avere sistemi fra i 20 e gli 80 miliardi di parametri installati su computer di medie dimensioni, a costi relativamente accessibili. Sono modelli con ottime capacità, che potrebbero essere utilizzati – per fare solo qualche esempio – per generare contenuti inappropriati, o virus informatici, o le istruzioni per fabbricare armi chimiche o biologiche.

Alla fine del 2023 lei ha pubblicato un libro dal titolo L’architetto e l’oracolo. Forme digitali del sapere da Wikipedia a ChatGPT. Qual era, allora, l’atteggiamento prevalente e quali cambiamenti ha visto in questi anni?

Nel 2023 l’atteggiamento principale era la sorpresa. Erano passati solo 5 anni dalla pubblicazione del famoso articolo Attention is all you need (2017) che ha presentato al mondo i modelli transformer [la famiglia di AI a cui appartiene ChatGPT, NdR]. Allora non ci aspettavamo che l’intelligenza artificiale generativa avrebbe fatto così tanti progressi in così poco tempo.

All’epoca il riferimento era soprattutto ChatGPT, mentre oggi i sistemi si sono moltiplicati. Abbiamo a disposizione piattaforme multimodali, di deep thinking e di deep research: una pluralità di modelli che hanno natura e scopi diversi. Per questo oggi non ha più senso parlare al singolare di intelligenza artificiale. Alcune di queste piattaforme, come accennavo, stanno risolvendo i problemi iniziali: ad esempio, le allucinazioni si sono ridotte molto con i modelli deep research e con le tecniche di RAG (Retrieval Augmented Generation). Possiamo dire che la deep research è oggi lo stato dell’arte delle intelligenze artificiali generative, ma le persone comuni continuano a utilizzare per lo più sistemi one shot, o comunque non selezionati in funzione dei compiti e delle necessità specifiche, e così continuano a esserci molti errori. Uno dei miei articoli più recenti riguarda il tema delle allucinazioni bibliografiche e mostra come – quando si chiede una bibliografia su un tema specifico – si possa passare dal 100% di allucinazioni di alcuni sistemi one shot, che inventano tutto, allo 0% su sistemi di deep research utilizzati con competenza.

Nel suo libro propone una metafora molto affascinante: la differenza tra gli “architetti delle conoscenze” (il modello Wikipedia), e il modello oracolare (delle intelligenze artificiali). Può spiegarcela?

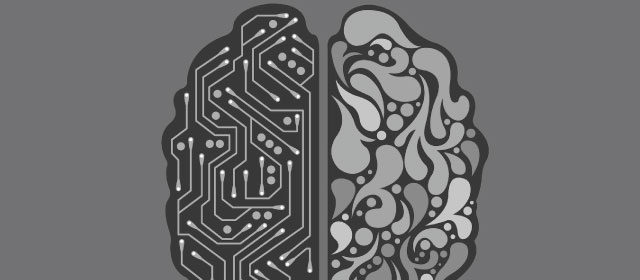

La metafora aiuta a sintetizzare due diverse modalità di lavoro. Da quando l’uomo produce conoscenza, cerca di sistematizzarla e organizzarla: da qui deriva il modello architettonico: quello delle enciclopedie e oggi di Wikipedia, per intenderci, che organizza un sistema di conoscenze dandogli forma e struttura.

Il modo in cui i sistemi di intelligenza artificiale generativa producono conoscenza invece è statistico-predittivo, quasi oracolare. Non intendo certo affermare che le AI dicano sempre la verità o predicano il futuro, ma che usano meccanismi di generazione per noi in parte oscuri, nel senso tecnico del termine. Funzionano su basi statistico-probabilistiche, attraverso reti neurali di cui possiamo conoscere valori, pesi, parametri, ma non possiamo prevedere con esattezza le risposte. Non è qualcosa che deve spaventare perché – se ci pensiamo – anche il modo con cui noi umani produciamo conoscenza è abbastanza oscuro: sistematizziamo le nostre idee, ma da dove scaturiscono? Può dipendere dal momento, dal contesto, ma molto spesso non sappiamo descriverlo con esattezza.

Penso che l’architettura e l’oracolarità debbano collaborare – come hanno già fatto in passato – per far sì che le AI generino informazioni e conoscenze che possano poi essere validate, verificate, strutturate. Direi che questa collaborazione stia già avvenendo: pensiamo alle sempre più diffuse tecniche di RAG. Le utilizza, per esempio, l’archivio storico del Parlamento europeo, che unisce un motore generativo per personalizzare l’output, che però – in prima battuta – è il risultato di una ricerca affidata a un sistema tradizionale, affidabile e garantito di information retrieval.

In ogni caso, vediamo il moltiplicarsi di sistemi che integrano aspetti generativi e aspetti di verifica delle informazioni. Nella deep research, ad esempio, quando l’AI incontra contenuti on-line che potrebbero essere non affidabili applica una sorta di ragionamento, confrontando e validando risultati provenienti da diverse fonti; ciò aiuta il sistema a rendersi conto del peso relativo da dare a fonti diverse prima di costruire il proprio output e presentarlo all’utente. In questo modo le AI generative stanno imparando a lavorare con l’ottica dell’architetto che verifica, valuta, controlla e produce informazioni altamente strutturate.

Possiamo ritenere creativi questi sistemi? E in che misura questa creatività può aumentare o diminuire quella umana?

Molti colleghi tenderebbero a rispondere negativamente a questa domanda, ma personalmente attribuirei una certa capacità creativa alle AI generative, per il semplice fatto che non “copiano”, non recuperano informazioni da un database. Per la prima volta abbiamo a disposizione sistemi che non si limitano ad aiutarci, ma scrivono e generano immagini o video al posto nostro. Producono risultati originali e, secondo me, in qualche misura anche creativi. Ciò però non significa che venga meno la nostra creatività, anche nell’uso di sistemi a loro volta in parte creativi.

Un altro aspetto su cui vorremmo il suo parere riguarda l’impatto delle intelligenze artificiali sulle capacità cognitive degli esseri umani. Pensa che possano indebolirle?

È un fenomeno già accaduto altre volte nella storia. Faccio un esempio: l’uso della calcolatrice ha indebolito le nostre capacità personali di calcolo? Sicuramente sì. Quando andavo a scuola, ho imparato a fare l’estrazione di radice con matita e quaderno, operazione che nessuno sa più fare a mano. Quindi alcuni strumenti indeboliscono certe capacità personali perché le esternalizzano: diventa chiaro quindi che, delegando totalmente a un’intelligenza artificiale generativa la stesura di un testo, indebolirò le mie capacità di produrre un testo.

L’essere umano che utilizza sistemi generativi è meno creativo, produttivo e impegnato dal punto di vista cognitivo? La risposta, credo, dipende da come vengono usati: utilizzati bene e con competenza, in forma di affiancamento e non di sostituzione, sono strumenti che – al contrario – possono aumentare l’impegno cognitivo.

Parlo della mia esperienza personale: lavoro in continuazione con strumenti di intelligenza artificiale generativa, ad esempio quando scrivo un articolo. Non li utilizzo per produrre un testo al mio posto, cosa che non sarebbe né etica né funzionale in termini qualitativi, ma per svolgere alcune tipologie di deep research, o per suggerire strategie e priorità (che confronto con le mie), o per funzionare come “discussant” di un testo, formulando possibili critiche e obiezioni. Non guadagno tempo: anzi, per produrre un articolo, mi servono più impegno e più lavoro che in passato. Il risultato, però, è spesso migliore.

Discorso diverso è se parliamo di situazioni come gli esami e i test scolastici e universitari: sempre più spesso l’AI generativa è usata per “barare”, per produrre risposte al posto nostro. Ovviamente è un problema, che rischia di abbassare la qualità dell’apprendimento. Per rispondere a questo problema occorre un ripensamento radicale delle modalità di verifica dell’apprendimento. Se continuiamo a preparare le nostre verifiche in maniera tradizionale, verranno svolte sempre più spesso dalle intelligenze artificiali generative. Dovremmo cambiare le nostre metodologie, e forse è anche ora di farlo.

A questo proposito, lei sta dando indicazioni ai suoi studenti su come utilizzare le intelligenze artificiali generative?

L’indicazione di base è: conoscere molto bene come si usano, altrimenti la qualità del lavoro peggiorerà. Se uno studente mi porta una bozza di tesi che contiene allucinazioni, vuol dire che non ha capito il loro funzionamento. Poi si dovrebbe capire quale sistema utilizzare in ogni specifica situazione, e infine comprendere che l’output deve essere sempre valutato criticamente. Il mio approccio si basa sul far lavorare molto gli studenti in progetti di gruppo e, se usano le AI generative, chiedo loro di specificare i prompt che hanno inviato, i contesti che hanno utilizzato e anche di confrontarsi tra di loro. Faccio lavorare i gruppi sullo stesso task, con prompt e contesti diversi, e poi chiedo di confrontare i risultati per vedere quali hanno funzionato meglio.

Questo lavoro rafforza le competenze e li abitua all’idea che non esiste un’unica risposta, sempre corretta, ma una pluralità di possibili risposte, a volte sbagliate e quasi sempre incomplete. Molto dipende da come poniamo le domande, dai contenuti che forniamo come contesto. Bisogna abituarsi a lavorare molto sui contesti informativi e sulle fonti. Non credo invece che serva a molto proibire l’utilizzo dell’intelligenza artificiale generativa: sarebbe come dire agli studenti di 20-30 anni fa di non usare Internet. Non solo sono battaglie di retroguardia: vuol dire far abdicare il sistema scolastico al suo compito di spiegare come utilizzare bene e in modo critico gli strumenti del mondo contemporaneo. Se vietiamo l’intelligenza artificiale generativa o vietiamo l’uso di Internet otteniamo lo stesso risultato: indeboliamo, e non rafforziamo, le competenze concretamente richieste non solo dal mercato del lavoro, ma, più in generale, dal mondo contemporaneo.

Secondo lei, con l’intelligenza artificiale, sta cambiando la forma della “nostra” intelligenza, quella umana?

La nostra intelligenza cambia in continuazione; quello che non cambia o lo fa molto più lentamente è il modo in cui funziona il nostro cervello, che è identico a quello di un homo sapiens di 30 o 40 mila anni fa. Adesso, però, stiamo iniziando a esternalizzare sempre di più alcune attività, che non riguardano più solo le capacità di memorizzare, ma anche quella di ragionare e produrre contenuti: la parte del cervello che possiamo immaginare come una sorta di “mente estesa” cresce e cambia sempre più rapidamente.

Quindi non cambia la natura della nostra intelligenza, cambia il modo in cui utilizziamo il nostro cervello e soprattutto il modo in cui utilizziamo le tante estensioni della nostra mente, che ormai – in qualche modo – costituiscono parte della nostra intelligenza.

Cosa possono riservarci in futuro le intelligenze artificiali?

Difficile rispondere. Mi ha molto colpito, a tal proposito, il risultato di una ricerca in cui è stato chiesto a 480 esperti ricercatori nel campo se questi sistemi comprendessero “davvero” il linguaggio. Le risposte possibili erano quattro: sicuramente sì, probabilmente sì, probabilmente no, sicuramente no. Gli esperti si sono distribuiti in modo praticamente uniforme su tutte e quattro le opzioni. Ciò dimostra come non ci sia consenso: ci troviamo in una situazione nuova e c’è tanto che non sappiamo ancora sulle possibili evoluzioni delle intelligenze artificiali. Questi sistemi hanno ancora molto spazio per sorprenderci: lo hanno fatto finora e ho l’impressione che continueranno a farlo.